El nuevo sistema emplea una red neuronal profunda para superar el desafío de la turbulencia de efecto suelo

Aterrizar los drones multi-rotor sin problemas es difícil. Una compleja turbulencia es creada por el flujo de aire de cada rotor que rebota del suelo a medida que el suelo crece cada vez más cerca durante un descenso. Esta turbulencia no se comprende bien, ni es fácil de compensar, especialmente en los drones autónomos. Es por eso que a menudo el despegue y el aterrizaje son las dos partes más difíciles del vuelo de un avión no tripulado. Los drones normalmente se tambalean y avanzan con lentitud hasta el aterrizaje, cuando finalmente se corta la energía y se dejan caer la distancia restante al suelo.

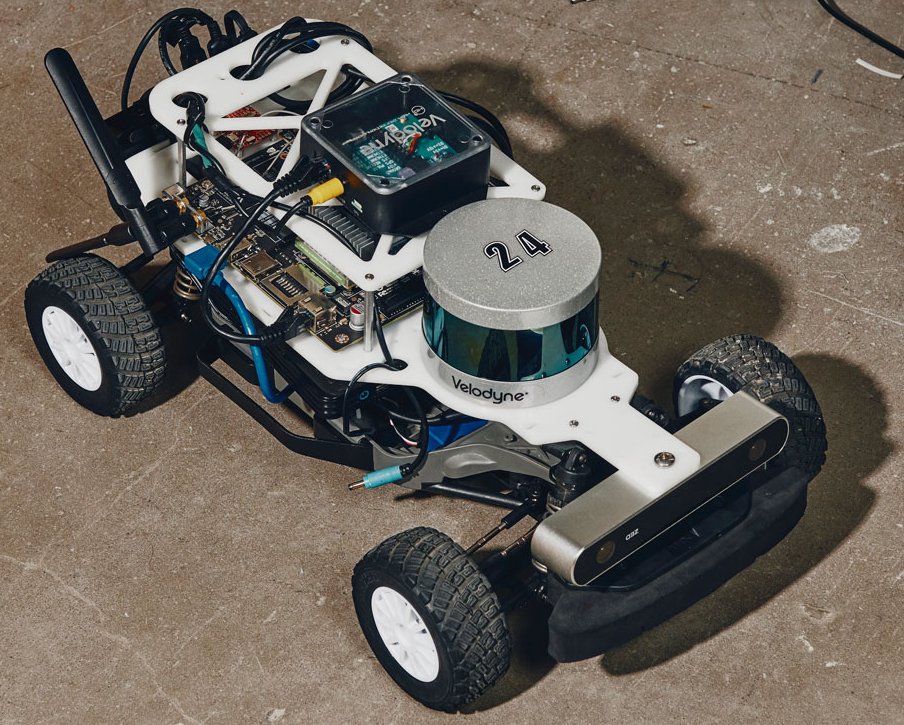

En el Centro de Tecnologías y Sistemas Autónomos (CAST – Center for Autonomous Systems and Technologies) de Caltech, los expertos en inteligencia artificial se han unido a expertos en control para desarrollar un sistema que utiliza una red neuronal profunda para ayudar a los drones autónomos a «aprender» cómo aterrizar de forma más segura y rápida, mientras se consume menos energía. El sistema que han creado, denominado «Neural Lander», es un controlador basado en aprendizaje que rastrea la posición y la velocidad del avión no tripulado, y modifica su trayectoria de aterrizaje y la velocidad del rotor para lograr el aterrizaje más suave posible.

«Este proyecto tiene el potencial de ayudar a los drones a volar de manera más suave y segura, especialmente en presencia de ráfagas de viento impredecibles, y consumir menos energía de la batería, ya que los drones pueden aterrizar más rápidamente», dice Soon-Jo Chung, profesor de Aeronáutica de Bren, División de Ingeniería y Ciencias Aplicadas (EAS) e investigador científico en JPL, que Caltech administra para la NASA. El proyecto es una colaboración entre los expertos en inteligencia artificial (AI) de Chung y Caltech, Anima Anandkumar, profesora de informática y ciencias matemáticas, y Yisong Yue, profesora asistente de informática y ciencias matemáticas.

Un documento que describe el Neural Lander se presentó en la Conferencia Internacional sobre Robótica y Automatización del Instituto de Ingenieros Eléctricos y Electrónicos (IEEE). Los coautores principales del artículo son los estudiantes graduados de Caltech Guanya Shi, cuya investigación de doctorado es supervisada conjuntamente por Chung y Yue, así como Xichen Shi y Michael O’Connell, que son estudiantes de doctorado en el Grupo de Control y Robótica Aeroespacial de Chung.

Las redes neuronales profundas (DNN) son sistemas de IA que se inspiran en sistemas biológicos como el cerebro. La parte «profunda» del nombre se refiere al hecho de que las entradas de datos se mueven a través de múltiples capas, cada una de las cuales procesa la información entrante de una manera diferente para descubrir detalles cada vez más complejos. Los DNN son capaces de aprendizaje automático, lo que los hace ideales para tareas repetitivas.

Para asegurarse de que el drone vuele suavemente bajo la guía del DNN, el equipo empleó una técnica conocida como normalización espectral, que suaviza las salidas de la red neuronal para que no realice predicciones muy variadas a medida que cambian las entradas y condiciones. Las mejoras en el aterrizaje se midieron al examinar la desviación de una trayectoria idealizada en el espacio 3D. Se realizaron tres tipos de pruebas: un aterrizaje vertical recto; un arco descendente de aterrizaje; y el vuelo en el que el avión no tripulado roza una superficie que se corta, como en el borde de una mesa, donde el efecto de la turbulencia del suelo variaría considerablemente.

El nuevo sistema reduce el error vertical en un 100 por ciento, lo que permite aterrizajes controlados y reduce la deriva lateral en hasta un 90 por ciento. En sus experimentos, el nuevo sistema logra un aterrizaje real en lugar de quedarse atrapado a unos 10 a 15 centímetros por encima del suelo, como suelen hacer los controladores de vuelo convencionales no modificados. Además, durante la prueba el Neural Lander produjo una transición mucho más suave cuando el dron hizo la transición de deslizarse sobre la mesa para volar en el espacio libre más allá del borde.

«Con menos errores, el Neural Lander es capaz de un aterrizaje más rápido y suave, y de deslizarse suavemente sobre la superficie del suelo», dice Yue. El nuevo sistema se probó en el aeródromo de tres pisos de CAST, que puede simular una variedad casi ilimitada de condiciones de viento en el exterior. Inaugurado en 2018, CAST es una instalación de 10.000 pies cuadrados donde los investigadores de EAS, JPL y la División de Ciencias Geológicas y Planetarias de Caltech se unen para crear la próxima generación de sistemas autónomos, mientras avanzan los campos de investigación de drones, exploración autónoma, y sistemas bioinspirados.

«Este esfuerzo interdisciplinario trae expertos de los sistemas de aprendizaje automático y control. Apenas hemos comenzado a explorar las ricas conexiones entre las dos áreas», dice Anandkumar.

Además de sus obvias aplicaciones comerciales, Chung y sus colegas han presentado una patente sobre el nuevo sistema. Éste podría ser crucial para los proyectos que actualmente se están desarrollando en CAST, incluido un transporte médico autónomo que podría aterrizar en lugares de difícil acceso. (como un tráfico bloqueado). «La importancia de poder aterrizar de forma rápida y sin problemas cuando se transporta a una persona lesionada no se puede exagerar», dice Morteza Gharib, Profesor de Aeronáutica e Ingeniería Bioinspirada; director de CAST; y uno de los principales investigadores del proyecto de ambulancia aérea.