El sistema usa etiquetas RFID para ubicarse en los objetivos. Podría beneficiar la fabricación robótica, drones colaborativos y otras aplicaciones.

Un nuevo sistema desarrollado en MIT utiliza etiquetas RFID para ayudar a los robots a localizar objetos en movimiento con una velocidad y precisión sin precedentes. El sistema podría permitir una mayor colaboración y precisión de los robots que trabajan en el empaquetado y el ensamblaje, y de enjambres de drones que realizan misiones de búsqueda y rescate.

En un documento que se presentará la próxima semana en el Simposio de USENIX sobre Diseño e Implementación de Sistemas en Red, los investigadores muestran que los robots que usan el sistema pueden ubicar objetos etiquetados en un promedio de 7,5 milisegundos, y con un error de menos de un centímetro.

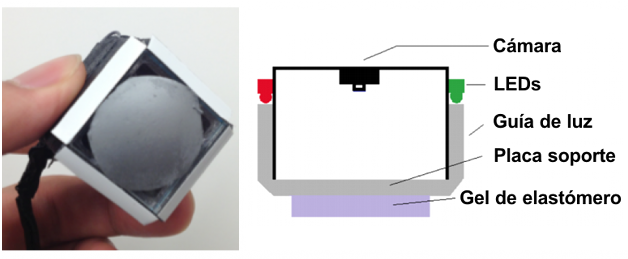

En el sistema, llamado TurboTrack, se puede aplicar una etiqueta RFID (identificación por radiofrecuencia) a cualquier objeto. Un lector envía una señal inalámbrica que se refleja en la etiqueta RFID y otros objetos cercanos, y rebota en el lector. Un algoritmo revisa todas las señales reflejadas para encontrar la respuesta de la etiqueta RFID. Luego, los cálculos finales aprovechan el movimiento de la etiqueta RFID, algo que generalmente disminuye la precisión, para mejorar la precisión de la localización.

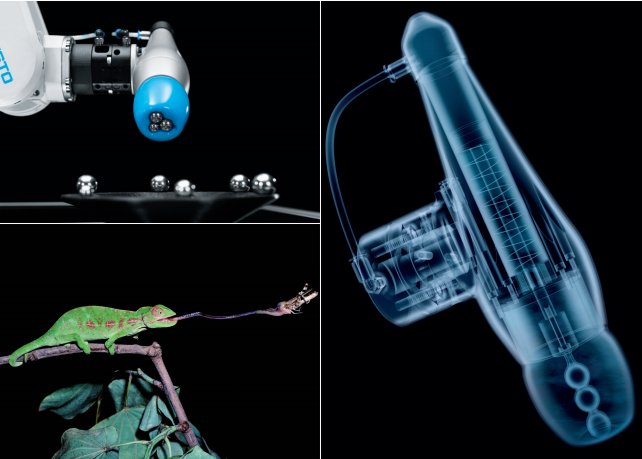

Los investigadores dicen que el sistema podría reemplazar la visión por computadora para algunas tareas robóticas. Al igual que con su contraparte humana, la visión de la computadora está limitada por lo que puede ver, y puede dejar de notar objetos en entornos desordenados. Las señales de radiofrecuencia no tienen estas restricciones: pueden identificar los objetivos sin visualización, dentro del desorden y a través de las paredes.

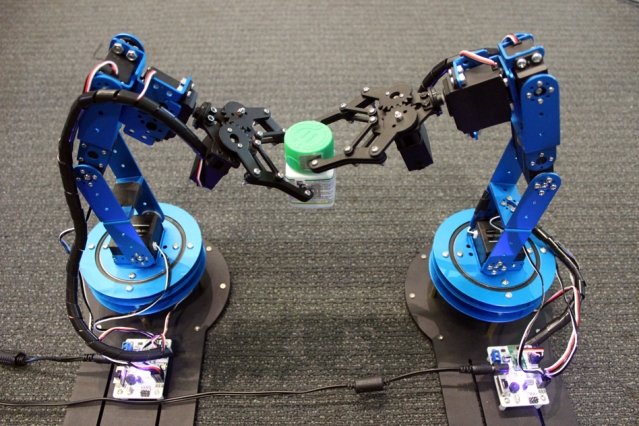

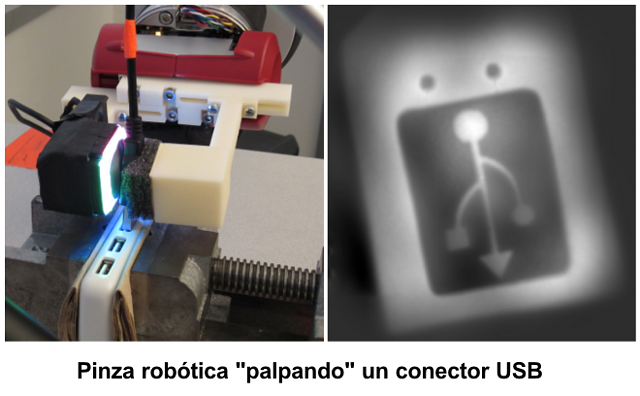

Para validar el sistema, los investigadores adjuntaron una etiqueta RFID a una tapa y otra a una botella. Un brazo robótico localizó la tapa y la colocó sobre la botella, sostenida por otro brazo robótico. En otra demostración, los investigadores rastrearon nanodrones equipados con RFID durante el acoplamiento, las maniobras y el vuelo. En ambas tareas, el sistema era tan preciso y rápido como los sistemas tradicionales de visión artificial, mientras trabajaban en escenarios donde falla la visión artificial, informan los investigadores.

“Si se usa señales de RF para tareas que normalmente se realizan con visión por computadora, no solo se habilita a los robots para que hagan cosas humanas, sino que también se puede hacer que hagan cosas sobrehumanas”, dice Fadel Adib, profesor asistente e investigador principal en el MIT Media Lab, y director fundador del Grupo de Investigación Signal Kinetics. «Y puede hacerlo de manera escalable, porque estas etiquetas RFID solo cuestan 3 centavos [de dólar] cada una».

En la fabricación, el sistema podría permitir que los brazos robóticos sean más precisos y versátiles en, digamos, recoger, ensamblar y empaquetar elementos a lo largo de una línea de ensamblaje. Otra aplicación prometedora es el uso de «nanodrones» de mano para misiones de búsqueda y rescate. Los nanodrones actualmente utilizan la visión por computadora y métodos para unir las imágenes capturadas con fines de localización. Estos drones a menudo se confunden en áreas caóticas, se pierden entre sí detrás de las paredes y no se pueden identificar de manera única. Todo esto limita su capacidad de, digamos, extenderse sobre un área y colaborar para buscar a una persona desaparecida. Usando el sistema de los investigadores, los nanodrones en enjambres podrían ubicarse mejor entre sí, para un mayor control y colaboración.

«Se puede permitir que un enjambre de nanodrones se forme de ciertas maneras, vuele en ambientes abarrotados, e incluso en entornos ocultos a la vista, con gran precisión», dice el primer autor Zhihong Luo, un estudiante graduado del Grupo de Investigación Signal Kinetics.

Los otros coautores del Media Lab en la publicación son el estudiante Qiping Zhang, el posdoctorado Yunfei Ma y el asistente de investigación Manish Singh.

Súper resolución

El grupo de Adib ha estado trabajando durante años en el uso de señales de radio para fines de seguimiento e identificación, como la detección de contaminación en los alimentos embotellados, la comunicación con los dispositivos internos del cuerpo, y la gestión de inventarios de almacenamientos.

Sistemas similares han intentado utilizar etiquetas RFID para tareas de localización. Pero estos vienen con compensaciones de precisión o velocidad. Para ser precisos, les puede llevar varios segundos encontrar un objeto en movimiento. Para aumentar la velocidad, pierden precisión.

El desafío fue lograr velocidad y precisión simultáneamente. Para hacerlo, los investigadores se inspiraron en una técnica de imagen llamada «imagen de súper resolución». Estos sistemas unen imágenes desde múltiples ángulos para lograr una imagen de resolución más fina.

«La idea era aplicar estos sistemas de súper resolución a las señales de radio», dice Adib. «A medida que algo se mueve, obtienes más perspectivas para rastrearlo, de modo que se puede explotar el movimiento para obtener precisión».

El sistema combina un lector RFID estándar con un componente «auxiliar» que se utiliza para localizar las señales de radiofrecuencia. El ayudante dispara una señal de banda ancha que comprende múltiples frecuencias, basándose en un esquema de modulación utilizado en la comunicación inalámbrica, llamado Multiplexación por división de frecuencias ortogonales.

El sistema captura todas las señales que rebotan contra objetos en el entorno, incluida la etiqueta RFID. Una de esas señales lleva una señal que es específica de una determinada etiqueta RFID, porque las señales RFID reflejan y absorben una señal entrante en un determinado patrón, correspondiente a bits 0 y 1, que el sistema puede reconocer.

Debido a que estas señales viajan a la velocidad de la luz, el sistema puede calcular un «tiempo de vuelo» (Time of Fly), que mide la distancia al calcular el tiempo que tarda una señal en viajar entre un transmisor y un receptor, para medir la ubicación de la etiqueta, así como los otros objetos en el entorno. Pero esto proporciona solo una figura de localización de estadio de béisbol, no una precisión menor a un centímetro.

Aprovechando el movimiento

Para ampliar la ubicación de la etiqueta, los investigadores desarrollaron lo que denominan un algoritmo de «súper resolución de espacio-tiempo».

El algoritmo combina las estimaciones de ubicación para todas las señales de rebote, incluida la señal RFID, que ha determinado usando el tiempo de vuelo. Usando algunos cálculos de probabilidad, reduce ese grupo a unas pocas ubicaciones potenciales para la etiqueta RFID.

A medida que la etiqueta se mueve, su ángulo de señal se altera ligeramente, un cambio que también corresponde a una determinada ubicación. El algoritmo puede usar ese cambio de ángulo para rastrear la distancia de la etiqueta a medida que se mueve. Al comparar constantemente el cambio de la medición de distancia con todas las demás mediciones de distancia de otras señales, puede encontrar la etiqueta en un espacio tridimensional. Todo esto sucede en una fracción de segundo.

«La gran idea es que, al combinar estas mediciones en el tiempo y en el espacio, se obtiene una mejor reconstrucción de la posición de la etiqueta», dice Adib.

«El trabajo informa sobre la precisión en el orden del sub-centímetro, que es muy impresionante para RFID», dice Lili Qiu, profesor de ciencias de la computación en la Universidad de Texas en Austin, cuya investigación se centra en las redes inalámbricas y las comunicaciones. «El documento propone una idea interesante que le permite a un «ayudante» transmitir una señal de banda ancha compatible con el protocolo RFID para lograr una alta precisión de seguimiento [y] desarrolla un […] marco para la localización de RF que fusiona las mediciones en el tiempo y en múltiples antenas. El sistema tiene potencial para admitir aplicaciones que son objetivo [de los investigadores], como ensamblaje robótico y nanodrones. … Sería muy interesante ver los resultados de las pruebas de campo en el futuro».

El trabajo fue patrocinado, en parte, por la Fundación Nacional de Ciencia.