El sistema en un chip capaz de detectar las señales en longitudes de onda sub-terahercios podría ayudar a conducir los vehículos sin conductor a través de la niebla y el polvo.

Los vehículos autónomos que dependen de sensores de imagen basados en la luz a menudo tienen dificultades para ver a través de algo que obstruye la visión, como la niebla. Pero los investigadores del MIT han desarrollado un sistema de recepción de radiación sub-terahercios que podría ayudar a conducir automóviles sin conductor cuando los métodos tradicionales fallan.

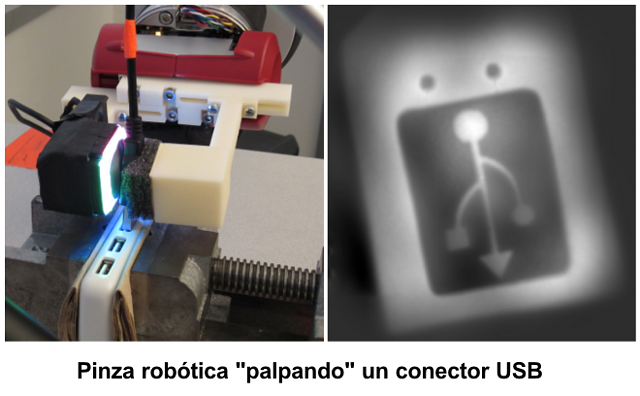

Las longitudes de onda de sub-terahercios, que se encuentran entre la radiación de microondas e infrarroja en el espectro electromagnético, se pueden detectar fácilmente a través de la niebla y las nubes de polvo, mientras que los sistemas de imágenes LiDAR basados en infrarrojos utilizados en vehículos autónomos tienen dificultades. Para detectar objetos, un sistema de imágenes basado en sub-terahercios envía una señal inicial a través de un transmisor; un receptor mide la absorción y reflexión de las longitudes de onda de los sub-terahercios del rebote. Eso envía una señal a un procesador que recrea una imagen del objeto.

Pero la implementación de sensores sub-terahertcios en autos sin conductor es un desafío. Un reconocimiento de objetos sensible y preciso requiere una fuerte señal de salida del receptor al procesador. Los sistemas tradicionales, hechos de componentes discretos que producen esas señales, son grandes y costosos. Existen matrices más pequeñas de sensores en chip, pero producen señales débiles.

En un artículo publicado en línea por el IEEE Journal of Solid-State Circuits, los investigadores describen una matriz bidireccional de recepción sub-terahercios en un chip que es mucho más sensible, lo que significa que puede capturar e interpretar mejor las longitudes de onda de sub-terahercios en presencia de mucho ruido de señal.

Para lograr esto, implementaron un esquema de píxeles a partir de una mezcla de señales independientes, llamados «detectores heterodinos», que generalmente son muy difíciles de integrar en chips. Los investigadores redujeron drásticamente el tamaño de los detectores heterodinos para que muchos de ellos puedan encajar en un denso chip. El truco consistió en crear un componente multipropósito compacto que pueda mezclar simultáneamente señales de entrada, sincronizar la matriz de píxeles y producir fuertes señales de banda base de salida.

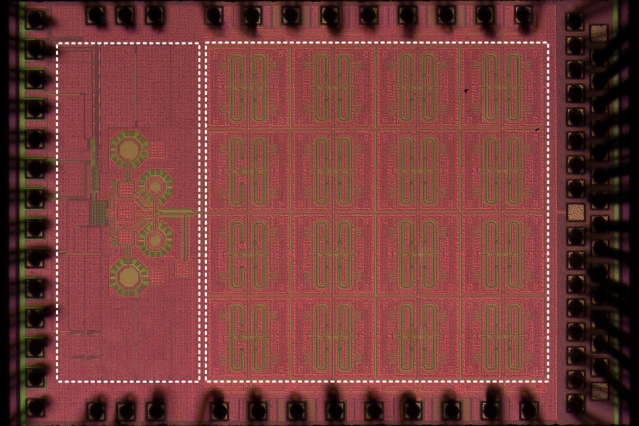

Los investigadores construyeron un prototipo, que tiene una matriz de 32 píxeles integrada en un dispositivo de 1,2 milímetros cuadrados. Los píxeles son aproximadamente 4.300 veces más sensibles que los píxeles en los sensores de matriz de sub-terahercios de hoy en día en chips. Con un poco más de desarrollo, es posible que el chip se pueda usar en autos sin conductor y robots autónomos.

«Una gran motivación para este trabajo es tener mejores ‘ojos eléctricos’ para vehículos autónomos y drones», dice el coautor Ruonan Han, profesor asociado de ingeniería eléctrica y ciencias de la computación, y director del Grupo de Electrónica Integrada Terahertz en el Microsystems Technology Laboratories (MTL) del MIT. «Nuestros sensores de sub-terahercios de bajo costo y en chip jugarán un papel complementario al LiDAR para cuando el entorno sea peligroso».

Junto a Han en la publicación, se encuentran el primer autor Zhi Hu y el coautor Cheng Wang, ambos estudiantes de doctorado en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación que trabajan en el grupo de investigación de Han.

Diseño descentralizado

La clave del diseño es lo que los investigadores denominan «descentralización». En este diseño, un píxel único, denominado píxel «heterodino», genera el ritmo de la frecuencia (la diferencia de frecuencia entre dos señales de sub-terahercios entrantes) y la «oscilación local», una señal eléctrica que cambia la frecuencia de una frecuencia de entrada. Este proceso de «mezcla descendente» produce una señal en el rango de megahercios que puede ser fácilmente interpretada por un procesador de banda base.

La señal de salida se puede usar para calcular la distancia de los objetos, de manera similar a como un LiDAR calcula el tiempo que tarda un láser en impactar un objeto y rebotar. Además, la combinación de las señales de salida de una matriz de píxeles y la dirección de los píxeles en una cierta dirección puede permitir imágenes de alta resolución de una escena. Esto permite no solo la detección, sino también el reconocimiento de objetos, algo fundamental en vehículos autónomos y robots.

La colección de píxeles heterodinos funciona solo cuando las señales de oscilación locales de todos los píxeles están sincronizadas, lo que significa que se necesita una técnica de sincronización de señales. Los diseños centralizados incluyen un solo concentrador que comparte señales de oscilación locales con todos los píxeles.

Estos diseños generalmente se usan en receptores de frecuencias más bajas y pueden causar problemas en las bandas de frecuencia de sub-terahercios, donde la generación de una señal de alta potencia desde un solo concentrador es notoriamente difícil. A medida que la matriz aumenta, la potencia compartida por cada píxel disminuye, lo que reduce la intensidad de la señal de banda base de salida, que depende en gran medida de la potencia de la señal de oscilación local. Como resultado, una señal generada por cada píxel puede ser muy débil, lo que lleva a una baja sensibilidad. Se ha comenzado a usar algunos sensores en chip de este diseño, pero están limitados a ocho píxeles.

El diseño descentralizado de los investigadores aborda este compromiso de sensibilidad a la escala. Cada píxel genera su propia señal de oscilación local, utilizada para recibir y mezclar la señal entrante. Además, un acoplador integrado sincroniza su señal de oscilación local con la de su vecino. Esto le da a cada píxel más potencia de salida, ya que la señal de oscilación local no fluye desde un centro global.

Una buena analogía para el nuevo diseño descentralizado es un sistema de riego, dice Han. Un sistema de irrigación tradicional tiene una bomba que dirige un poderoso flujo de agua a través de una red de tuberías que distribuye agua a muchos sitios de rociadores. Cada aspersor escupe agua con un flujo mucho más débil que el flujo inicial de la bomba. Si se desea que los rociadores lancen agua a la misma frecuencia, eso requeriría otro sistema de control.

El diseño de los investigadores, por otro lado, le da a cada sitio su propia bomba de agua, eliminando la necesidad de conectar tuberías, y le da a cada aspersor su propia salida poderosa de agua. Cada aspersor también se comunica con su vecino para sincronizar sus pulsaciones. «Con nuestro diseño, esencialmente no hay límite para la escalabilidad», dice Han. «Puedes tener tantos sitios como quieras, y cada sitio aún bombea la misma cantidad de agua… y todas las bombas pulsan juntas».

Sin embargo, potencialmente, la nueva arquitectura hace que la huella de cada píxel sea mucho más grande, lo que plantea un gran desafío para la integración a gran escala y de alta densidad en forma de matriz. En su diseño, los investigadores combinaron varias funciones de cuatro componentes tradicionalmente separados (antena, mezclador, oscilador y acoplador) en un único componente de «multitarea» dedicado a cada píxel. Esto permite un diseño descentralizado de 32 píxeles.

«Diseñamos un componente multifuncional para un diseño [descentralizado] en un chip y combinamos algunas estructuras discretas para reducir el tamaño de cada píxel», dice Hu. «Aunque cada píxel realiza operaciones complicadas, mantiene su compacidad, por lo que aún podemos tener una matriz densa a gran escala».

Guiado por frecuencias

Para que el sistema pueda medir la distancia de un objeto, la frecuencia de la señal local de oscilación debe ser estable.

Con ese fin, los investigadores incorporaron en su chip un componente llamado bucle de bloqueo de fase, que bloquea la frecuencia de sub-terahercios de las 32 señales de oscilación local a una referencia estable de baja frecuencia. Debido a que los píxeles están acoplados, sus señales de oscilación locales comparten una fase y frecuencia idénticas y de alta estabilidad. Esto asegura que se pueda extraer información significativa de las señales de banda base de salida. Toda esta arquitectura minimiza la pérdida de señal y maximiza el control.

«En resumen, logramos una matriz coherente, al mismo tiempo con una potencia de oscilación local muy elevada en cada píxel, por lo que cada píxel alcanza una alta sensibilidad», dice Hu.