GIF Dan Saelinger

Los robots han caminado sobre piernas durante décadas. Los robots humanoides más avanzados de la actualidad pueden pisar sobre superficies planas e inclinadas, subir y bajar escaleras y avanzar por terrenos difíciles. Algunos incluso pueden saltar. Pero a pesar del progreso, los robots con piernas aún no pueden comenzar a igualar la agilidad, eficiencia y fuerza de los humanos y animales.

Los robots caminantes existentes consumen mucha energía y pasan demasiado tiempo en el taller. Con demasiada frecuencia fallan, caen y se rompen. Para que los ayudantes robóticos con los que hace tiempo soñamos se conviertan en realidad, estas máquinas tendrán que aprender a caminar como nosotros.

Debemos construir robots con piernas porque nuestro mundo está diseñado para piernas. Pasamos por espacios estrechos, nos movemos sobre obstáculos, subimos y bajamos escalones. Los robots con ruedas u orugas no pueden moverse fácilmente por los espacios que hemos optimizado para nuestros propios cuerpos.

De hecho, muchos humanoides tienen piernas similares a las nuestras, con caderas, rodillas, tobillos y pies. Pero las similitudes por lo general terminan ahí: si se comparan, por ejemplo, las fuerzas que estos robots ejercen en el suelo con las que ejerce un humano, se descubre que a menudo son bastante diferentes. La mayoría de los humanoides, descendientes de los primeros brazos robóticos industriales, controlan sus extremidades para seguir trayectorias específicas de la forma más precisa y rígida posible. Sin embargo, la locomoción con piernas no requiere tanto control de posición como control de fuerza, con mucha flexibilidad y elasticidad, conocidas en robótica como flexibilidad, como para permitir contactos inesperados.

Varios grupos de investigación han estado tratando de construir robots que sean menos rígidos y que puedan moverse de una manera más dinámica y humana. Tal vez el robot más famoso sea Atlas, de Boston Dynamics, un humanoide que puede correr en terrenos duros y blandos, saltar sobre troncos caídos e incluso retroceder. Pero nuevamente, cuando comparamos el movimiento de incluso los robots más sofisticados con lo que pueden lograr los animales, las máquinas se quedan cortas.

¿Qué nos falta? La tecnología no es el mayor obstáculo: los motores son lo suficientemente poderosos, los materiales son lo suficientemente fuertes, y las computadoras son lo suficientemente rápidas. Más bien, el factor limitante parece ser nuestra comprensión básica de cómo funciona la locomoción sobre patas.

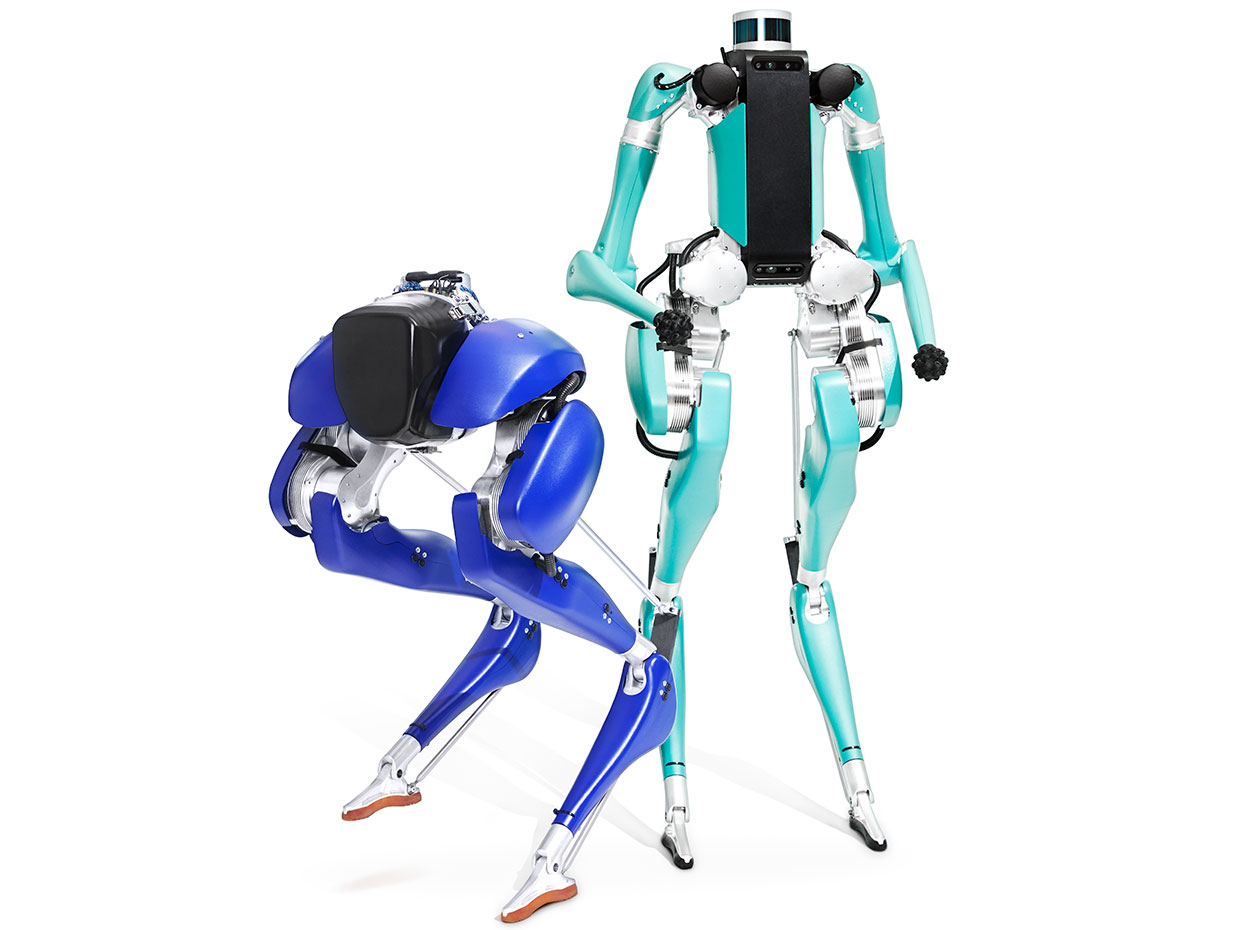

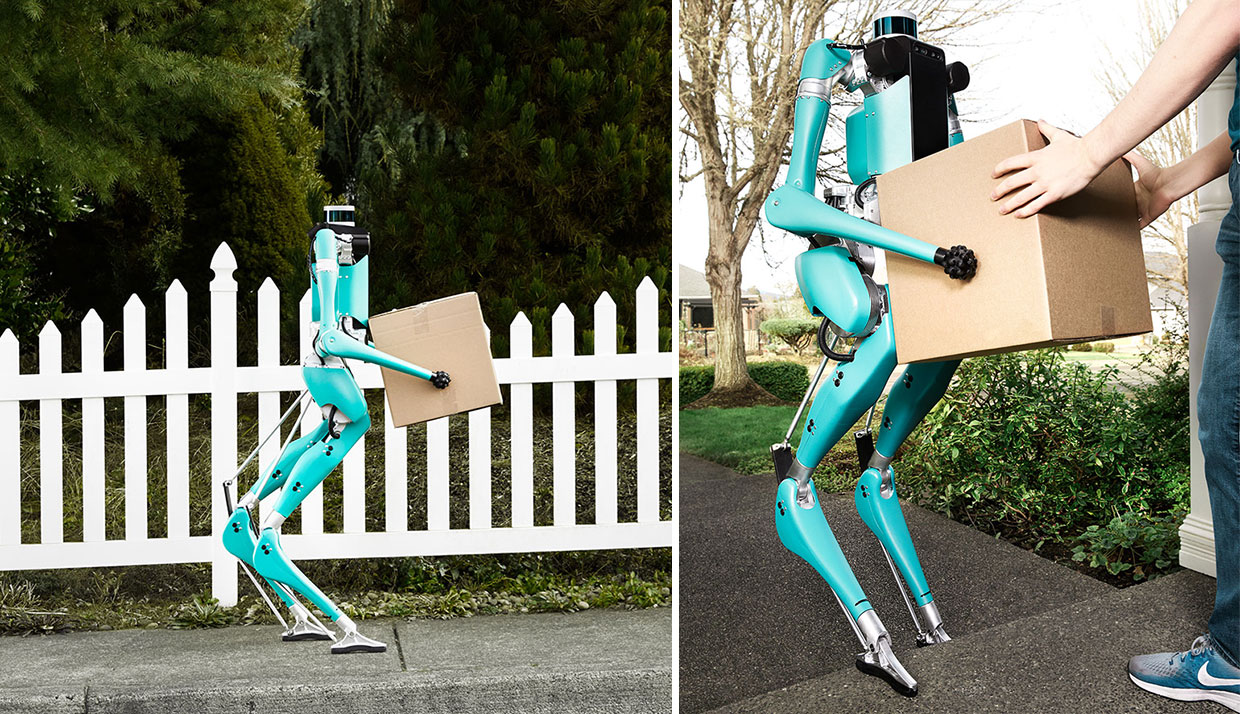

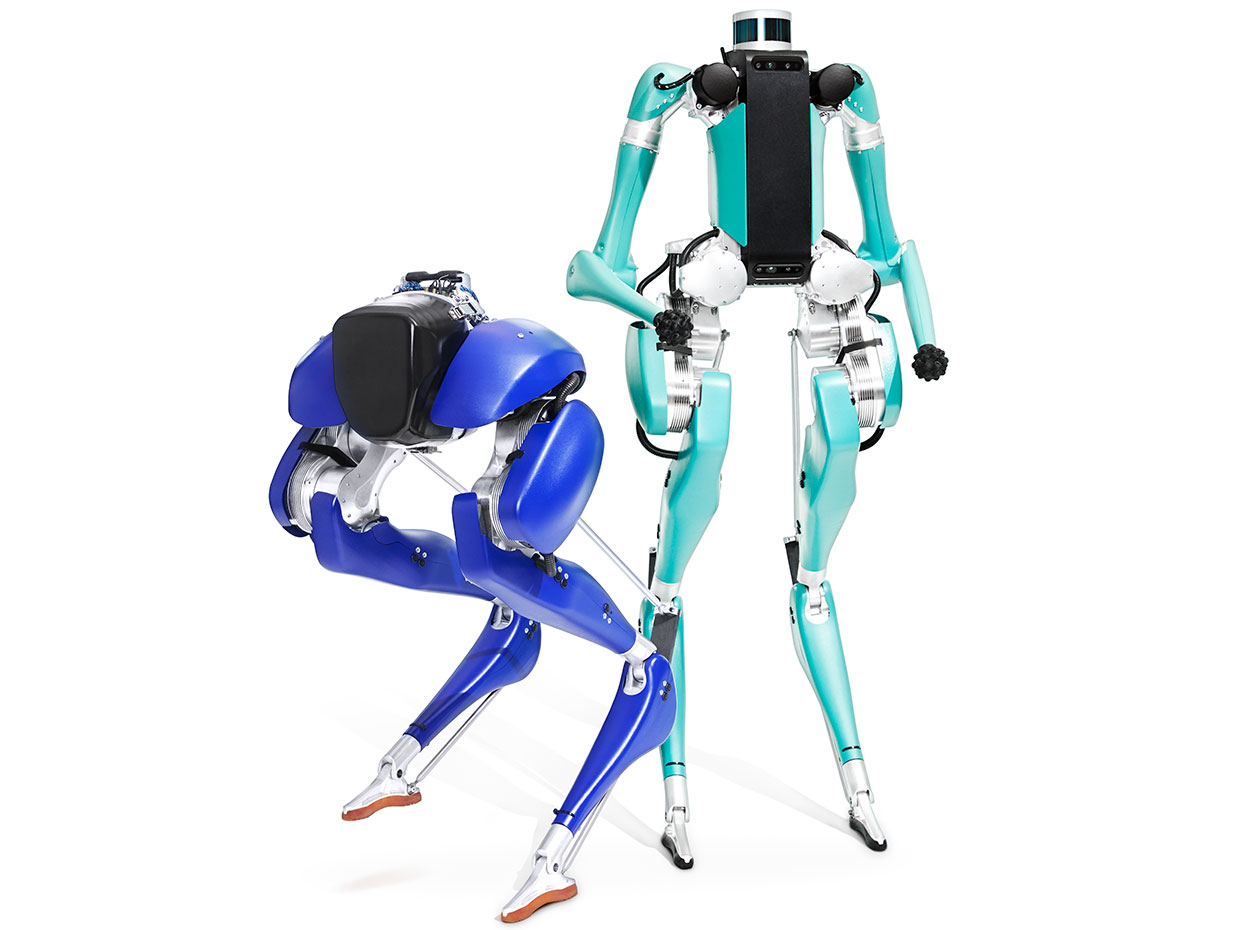

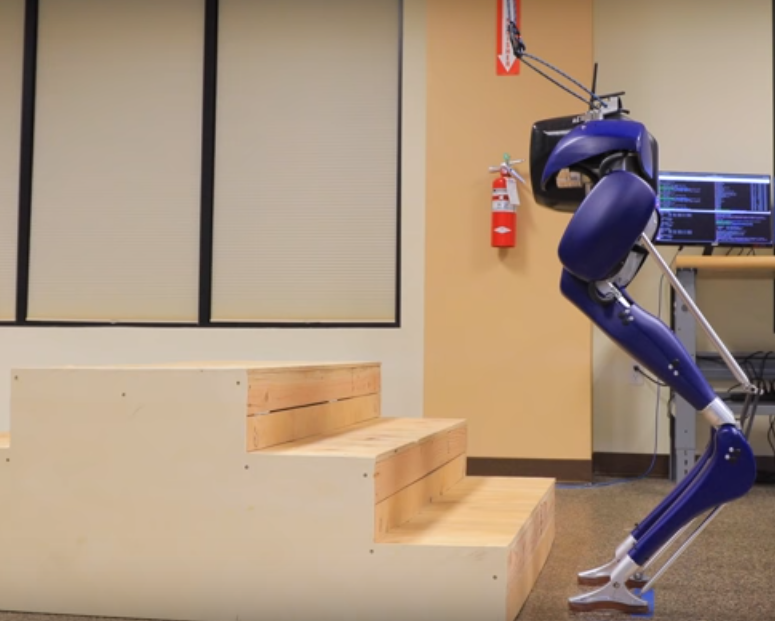

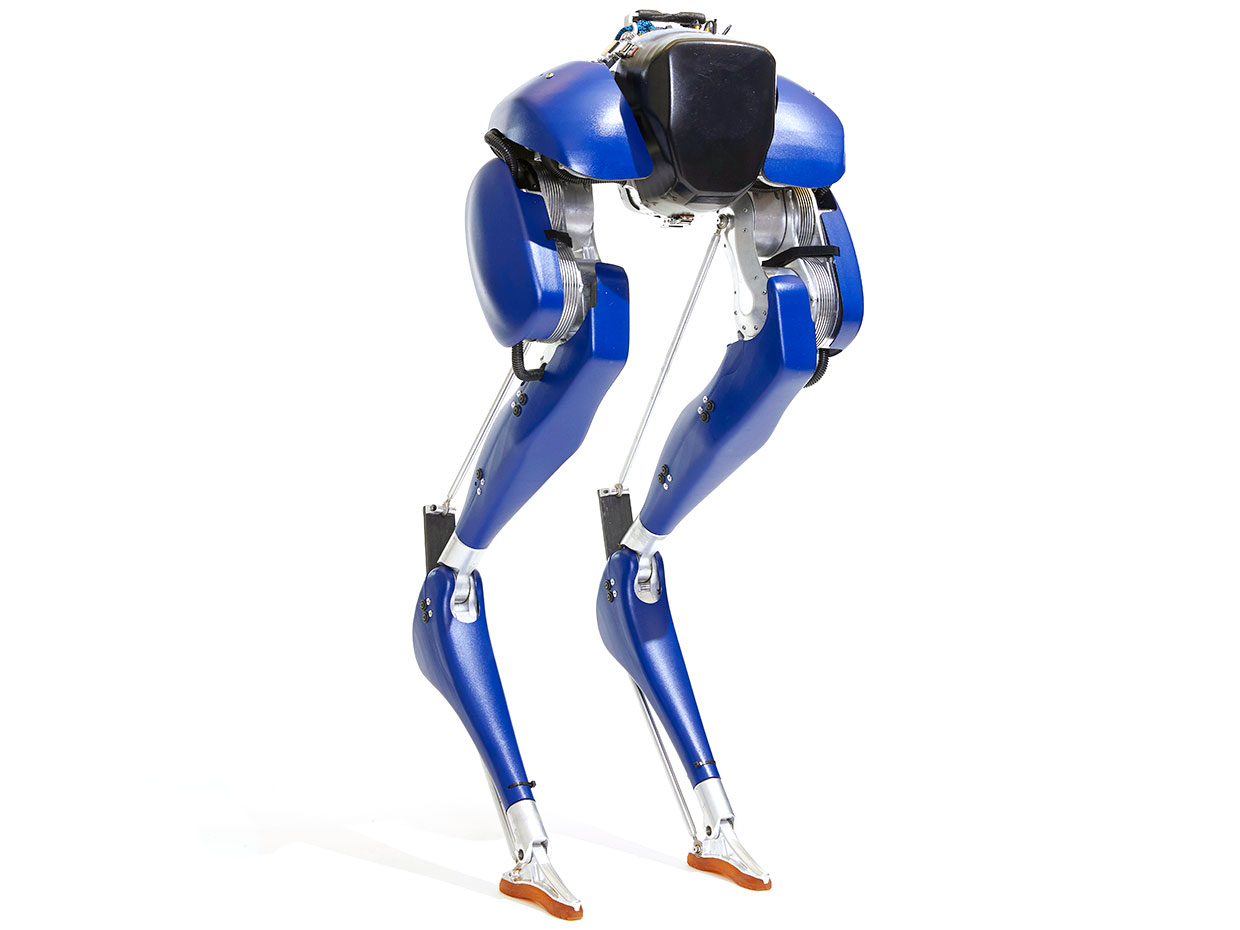

Fotos: Dan Saelinger. Droides de la vida real: Agility Robotics diseñó sus robots con piernas Cassie [izquierda] y Digit para moverse de una manera más dinámica que los robots normales.

En el Dynamic Robotics Laboratory de la Universidad del Estado de Oregon, el autor dirige un grupo de investigadores que buscan identificar los principios subyacentes de la locomoción de las piernas y aplique sus descubrimientos a los robots. También es el cofundador y director de tecnología de Agility Robotics, una empresa con sede en Albany, Oregón, que está explorando los usos comerciales de la robótica con movilidad sobre piernas.

En 2017, presentaron Cassie, una plataforma bípeda que han vendido a varios grupos de investigación. Pronto tendrán un nuevo robot listo para salir al mundo: Digit, que tiene patas similares a las de Cassie, pero también cuenta con sensores de percepción y un par de brazos que utilizará para la estabilidad y, en el futuro, la manipulación.

Tanto por medio del laboratorio como de la compañía, están trabajando para lograr un futuro en el que los robots puedan ir a cualquier lugar donde vaya la gente. Se cree que los robots con piernas dinámicas algún día ayudarán a cuidar de las personas mayores y enfermas en sus hogares, ayudarán en los esfuerzos de salvamento en incendios y terremotos, y entregarán paquetes en las puertas de las casas.

Las piernas robóticas también permitirán exoesqueletos y extremidades protésicas motorizadas para dar más movilidad a las personas con discapacidades. Finalmente traerán los robots imaginados en la ciencia ficción a nuestras vidas diarias.

CLIC PARA VER VIDEO

Algunas aves corren mejor de lo que pueden volar, si es que pueden volar. Avestruces, pavos, gallinas y codornices no pueden volar como un halcón, pero son rápidas con sus patas. En colaboración con Monica Daley del Royal Veterinary College de la Universidad de Londres, el autor y sus colegas han pasado innumerables horas observando a las aves caminando y corriendo en el laboratorio. Quieren entender cómo es que estos animales se mueven de manera tan ágil y eficiente, ¡la mayoría de estas máquinas emplumadas son impulsadas solo por semillas!

En un experimento, una gallina de Guinea corre por una pista cuando y pisa un hoyo oculto por una hoja de papel de seda. El ave no sabía que iba a meterse en un bache a media pierna de profundidad; sin embargo, el animal no pierde un paso, su pierna se estira para ajustarse a la caída a medida que pasa el obstáculo. Lo que sucede aquí es bastante notable: el cerebro del ave no tiene que sentir ni reaccionar ante la perturbación porque sus patas pueden manejarse por sí mismas.

Esto ofrece una visión importante para los diseñadores de robots: si primero construyes tu robot y luego intentas programarlo para que sea ágil, es probable que estés condenado a fallar. Al igual que con las aves de Guinea, la agilidad de un robot se derivará en gran parte de las propiedades mecánicas inherentes de su cuerpo, o lo que los robotistas llaman dinámica pasiva. Y esto se ha descuidado en la mayoría de los proyectos de robots con patas. Al diseñar cuidadosamente la dinámica pasiva de un robot en paralelo con el control de software como un sistema integrado se aumentan las posibilidades de crear un robot que se aproxime al rendimiento de un animal.

Ahora, vale la pena señalar que, aunque uno se inspire en los animales, no replican la forma del pie de un pájaro o la disposición de músculos y huesos en una pierna humana. En su lugar, se desea capturar la física de la locomoción animal y extraer de ella un modelo matemático que se pueda entender, probar en simulaciones por computadora y luego implementarlo en robots reales. Debido a que están utilizando metal y componentes electrónicos en lugar de huesos y cerebros para construir estos robots, pueden parecer muy diferentes de un animal y al mismo tiempo tener la misma física.

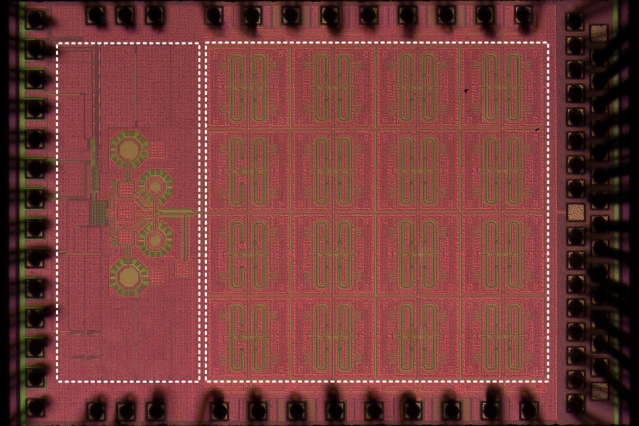

Uno de los modelos matemáticos más simples consiste en una masa puntual (que representa la parte superior del cuerpo) unida a un par de resortes ideales, que representan las piernas. Este modelo, conocido como modelo de masa de resorte, es una simplificación, por supuesto: se asemeja a un dibujo de palotes y no tiene en cuenta que las piernas tienen articulaciones, o que los pies no tocan el suelo en puntos discretos. Aún así, el modelo de muelles de resortes puede producir resultados sorprendentes: en las simulaciones, puede generar casi todas las maneras de caminar y correr observadas en personas y animales.

Foto: Oregon State University. Primeros pasos: Las piernas de ATRIAS no se parecen a las de una persona, pero el robot fue la primera máquina en demostrar dinámicas de andar de forma humana.

Primeros pasos:

Para probar el modelo de masa de resorte en una máquina, el grupo en Oregon State, en colaboración con Hartmut Geyer de la Universidad Carnegie Mellon y Jessy Grizzle de la Universidad de Michigan, desarrolló ATRIAS, un robot bípedo cuyo nombre es un acrónimo que refleja la premisa principal: Supongamos que el robot es una esfera. La idea era que la dinámica pasiva del robot pudiera acercarse lo más posible a la reproducción de la masa puntual con patas elásticas.

Construyeron cada pata con varillas de fibra de carbono livianas, dispuestas en una estructura en forma de paralelogramo conocida como enlace de cuatro barras. Esta estructura minimiza la masa de las piernas y su inercia asociada, aproximándose al modelo de masa de resorte. También equiparon la parte superior de las piernas con resortes de fibra de vidrio, que encarnan físicamente la parte de «resorte» del modelo, manejando los impactos en el suelo y almacenando energía mecánica.

Al principio, ATRIAS apenas podía sostenerse, y se lo sostuvo con una atadura por arriba de él. Pero a medida que refinaron su controlador, que hacía un seguimiento de la velocidad y la inclinación del cuerpo, el robot dio sus primeros pasos y pronto estaba caminando por el laboratorio. A continuación ATRIAS aprendió a recuperarse de las perturbaciones, que en un experimento consistió en que los alumnos le lanzaran pelotas. También llevaron a ATRIAS al campo de fútbol de la universidad, lo aceleraron a una velocidad máxima de 7,6 kilómetros por hora y luego, por supuesto, lo detuvieron rápidamente en la zona final.

CLIC PARA VER VIDEO

Para comprender mejor cómo lo estaba haciendo el robot, imagine que usted tiene los ojos vendados y camina sobre zancos con la parte superior del cuerpo envuelta en una alfombra, de modo que no puede usar los brazos para equilibrarse. Todo lo que se puede hacer es seguir caminando, y eso es lo que hizo ATRIAS. Incluso fue capaz de manejarse ante obstáculos, como una pila de madera contrachapada colocada en su camino.

Si bien era importante la agilidad, también era fundamental que ATRIAS fuera económico en consumo de energía. Confirmaron que lo era al medir un parámetro que se conoce como costo de transporte (COT). Se define como la relación entre el consumo de energía y peso por velocidad, y se usa para comparar la eficiencia energética en cómo se mueven los animales y las máquinas. Cuanto menor sea el COT, mejor. Una persona que camina, por ejemplo, tiene un COT de 0,2, mientras que los robots humanoides convencionales tienen valores mucho más altos, entre 2 y 3, según algunas estimaciones [PDF]. Los experimentos mostraron que ATRIAS, con su manera de caminar, tenía un COT de 1,13 [PDF], demostrando beneficios de eficiencia de robots dinámicos [PDF]. De hecho, unas cuantas baterías pequeñas de polímero de litio, del tipo que se usa en los automóviles controlados por radio, podrían mantener el funcionamiento de ATRIAS durante aproximadamente una hora.

También midieron las fuerzas [PDF] que el robot ejercía en el suelo. Colocaron ATRIAS, que pesa 72,5 kilogramos (aproximadamente lo mismo que una persona) en una placa de fuerza, un instrumento que se usa a menudo en medicina deportiva para evaluar la marcha de una persona al medir las fuerzas de reacción contra el suelo. Mientras el robot caminaba, grabaron los datos de fuerza aplicada. Luego reemplazaron a ATRIAS por uno de los alumnos y registraron sus pasos. Cuando graficaron las fuerzas de reacción del terreno a lo largo del tiempo, los dos conjuntos de datos tenían exactamente la misma forma. Por lo que se sabe hasta el momento, es la implementación robótica más realista de la dinámica de la marcha humana que se haya realizado.

Los resultados confirmaron que un simple sistema accionado por masa de resorte es algo que se puede construir en un robot; habilitando muchos de los rasgos buscados, tales como eficiencia, robustez y agilidad; y llegar al núcleo de lo que es la locomoción bípeda. Ya era hora de que construyeran el siguiente robot.

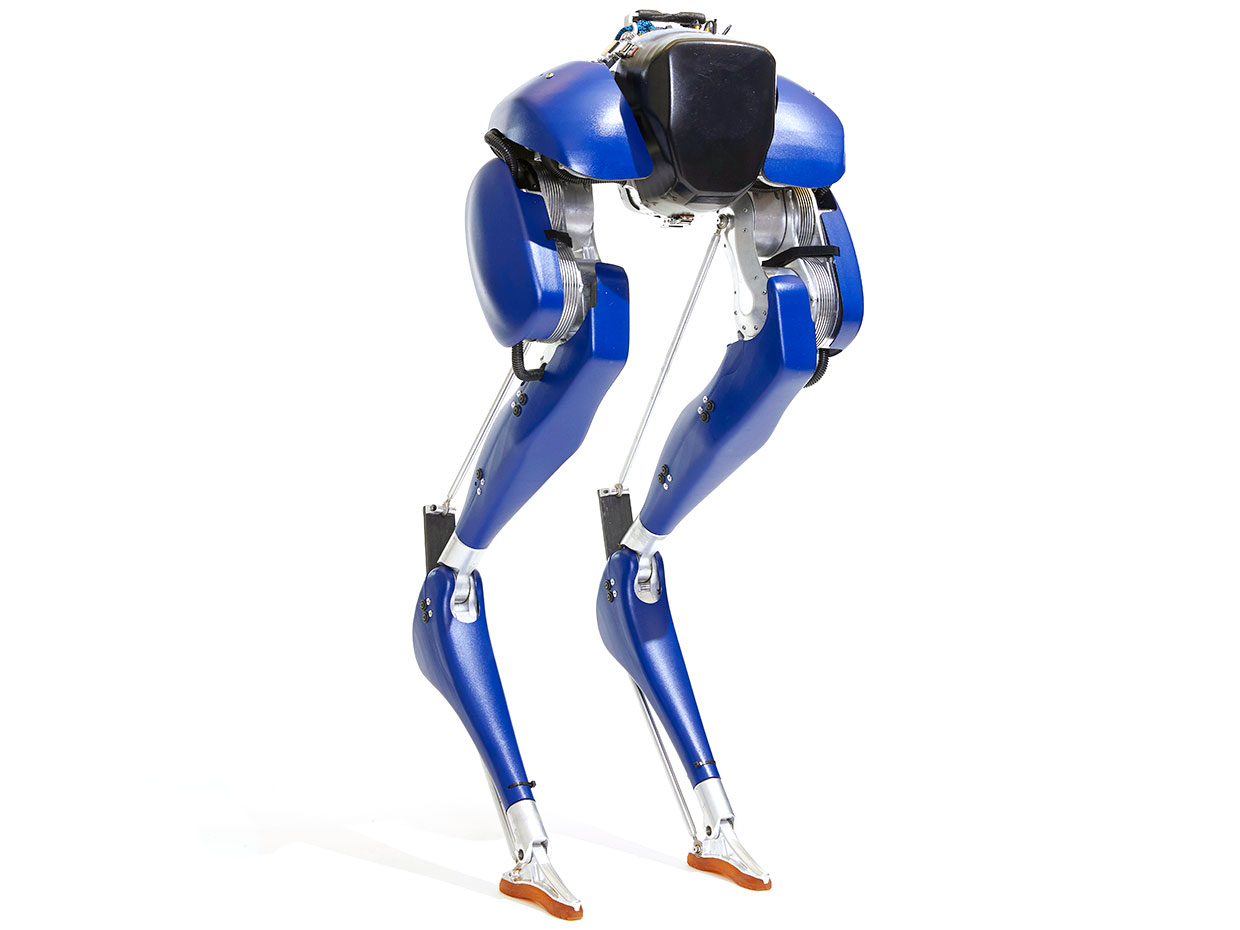

Foto: Dan Saelinger. Caminante dinámico: Para moverse con agilidad por un terreno complejo, Cassie usa cinco motores y dos resortes en cada pierna.

Y establecieron una vara elevada: querían que Cassie pudiera correr a través de un bosque, capaz de manejarse en terrenos difíciles operando durante horas con una batería, sin correa de seguridad.

Cassie se basa en los mismos conceptos desarrollados para ATRIAS, pero decidieron darle un nuevo tipo de piernas. Usaron dos motores para alimentar la conexión de cuatro barras en cada tramo de ATRIAS. Esta disposición minimizó su masa, pero hubo una complicación: durante parte del ciclo de pasos, un motor actuaba como un freno del otro, lo que le costaba una energía significativa e innecesaria. Para Cassie, estudiaron configuraciones alternativas para las piernas [PDF] para eliminar ese efecto. El nuevo diseño permite que los motores sean más pequeños y, por lo tanto, hace que el robot sea incluso más eficiente que ATRIAS.

Es importante tener en cuenta que la configuración de la pierna de Cassie fue resultado de este análisis. El hecho de que la pata se asemeje a la de un avestruz u otro terópodo puede ser una señal de que están en el camino correcto, pero el objetivo nunca fue crear un robot que, con unas pocas plumas bien colocadas, pudiera encajar con una multitud de avestruces.

CLIC PARA VER VIDEO

Cada una de las piernas de Cassie tiene cinco ejes de movimiento, o grados de libertad en el lenguaje robótico, cada uno impulsado por un motor. Las caderas tienen tres grados de libertad, similares a las nuestras, permitiendo que la pierna gire en cualquier dirección. Otros dos motores potencian las articulaciones en la rodilla y el pie. Cassie tiene grados adicionales de libertad en su espinilla y tobillo; estos son pasivos, no controlados por motores, sino más bien unidos a resortes, que ayudan al robot a moverse a través de terrenos complejos que los humanoides de pies planos no pueden manejar.

Las nuevas piernas de Cassie requerían un controlador de bajo nivel más sofisticado que el de ATRIAS. Con ATRIAS, la extensión de una pierna se logró simplemente mediante la aplicación de pares iguales y opuestos con los dos motores. Con la pierna de Cassie, mover el pie en una dirección específica requiere calcular diferentes pares de torsión para cada motor. Para hacer eso, el controlador debe tener en cuenta la inercia de las patas, así como la dinámica de los motores y cajas de engranajes.

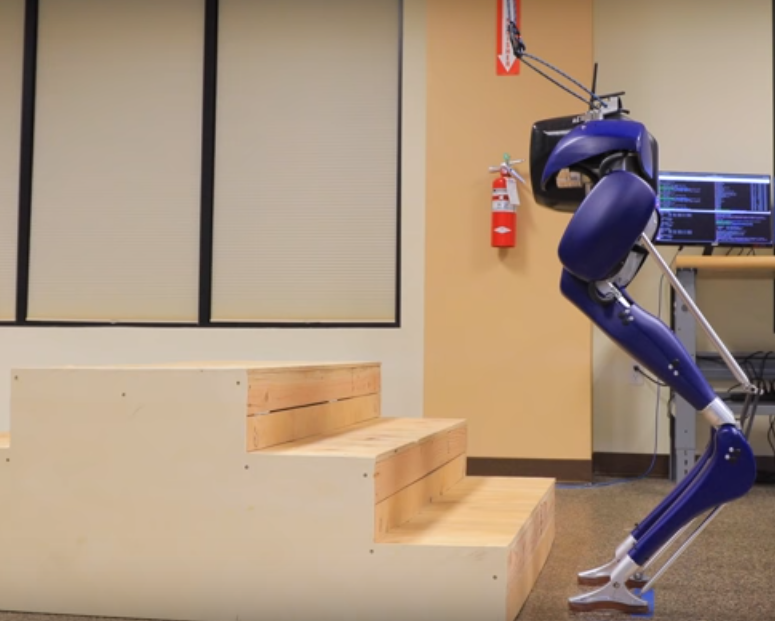

Gif: Dan Saelinger. Paso a paso: El controlador de Cassie usa posiciones planeadas en pasos y balanceo dinámico para permitir que el robot suba las escaleras.

Es cierto que el problema de control se volvió más complejo, pero este método permite un mejor rendimiento y una gama de comportamientos mucho más amplia. Cassie puede alcanzar una velocidad de marcha de 5 km/h usando uno de los controladores iniciales. El consumo de energía varía de 100 vatios (cuando está de pie) a aproximadamente 300 vatios (en marcha), y la batería de iones de litio permite aproximadamente 5 horas de funcionamiento continuo. Las nuevas piernas también le permiten a Cassie moverse de una manera que ATRIAS no podría. Y gracias a una articulación motorizada en el pie, puede colocarse en su lugar sin tener que mover sus pies constantemente como lo hace ATRIAS.

Cassie también pesa solo 31 kg, la mitad que ATRIAS. Es posible cargar dos Cassies en el baúl de un automóvil en menos de un minuto. Y es mucho más robusto: las partes de su cuerpo están hechas de aluminio y fibra de carbono, y una cubierta protectora hecha de cloruro de polivinilo acrílico termoformado, un plástico fuerte que lo protege de colisiones y caídas.

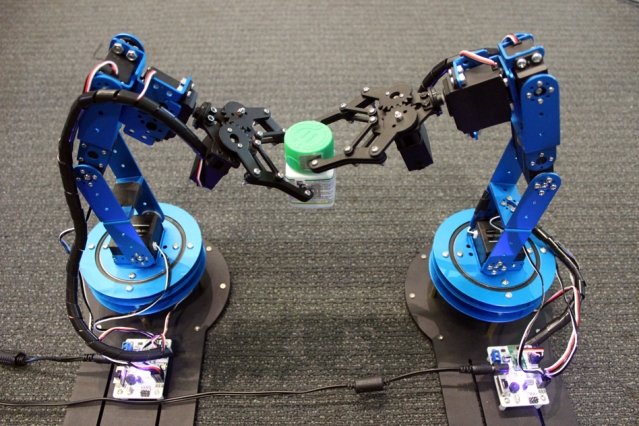

Cassie todavía no corre por los bosques. Pero lo han probado al aire libre, sin amarres de seguridad, y ha caminado sobre tierra, hierba y hojas, caminos desparejos. Ahora están aprendiendo cómo integrar comportamientos dinámicos con planificación de movimiento [PDF] , lo que le permite subir escaleras, por ejemplo. También están trabajando en otra característica que podría hacer que un robot como Cassie sea mucho más útil: brazos.

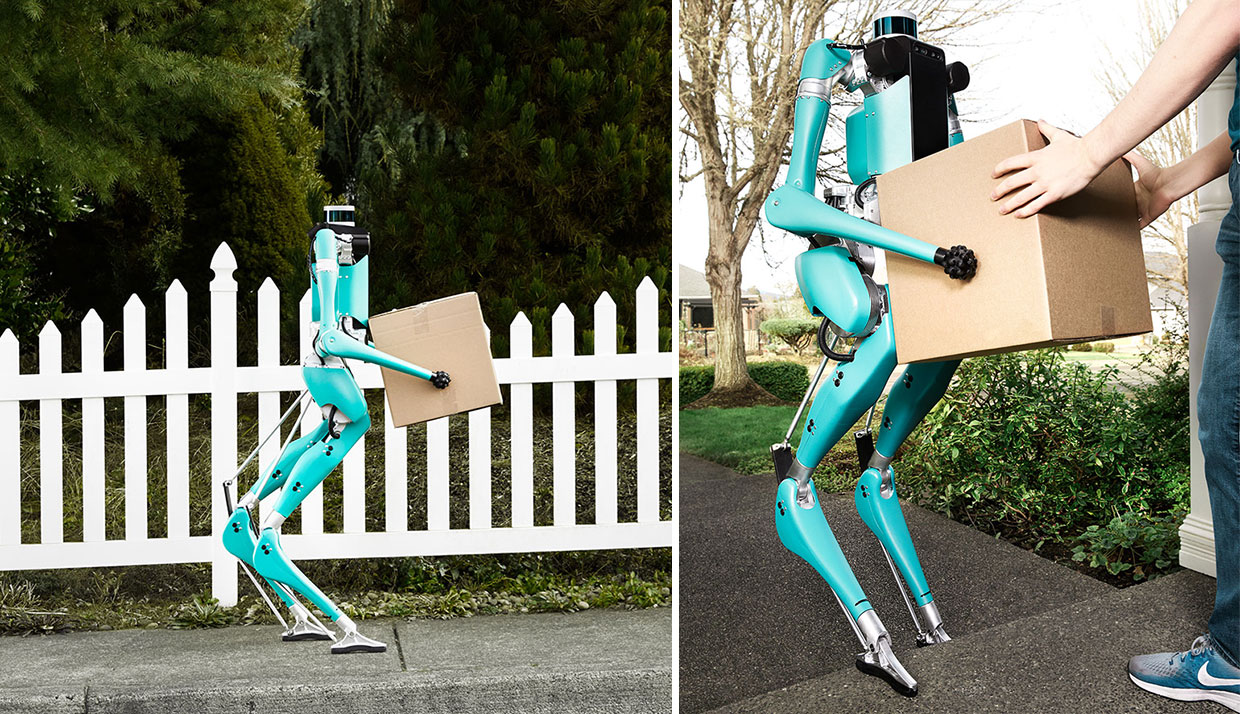

Foto: Dan Saelinger. Cuerpo a estrenar: Digit tiene patas similares a las de Cassie, pero también tiene un torso lleno de sensores y un par de brazos diseñados para ayudar con la movilidad y el equilibrio.

de Cassie. Tiene piernas similares, pero agregaron un torso y un par de brazos. Los brazos están diseñados para ayudar con la movilidad y el equilibrio del robot, ya que giran en coordinación con la marcha. También permitirán que Digit se cuide a sí mismo al caer, y reorientará su cuerpo para volver a subir.

Digit tiene algo más que Cassie no tenía: la percepción integrada. Agregaron numerosos sensores al robot, incluido un LIDAR sobre el torso. Estos sensores ayudarán a recopilar datos para permitir que el robot navegue por un mundo lleno de obstáculos, como habitaciones desordenadas y escaleras, y confiar en la dinámica estable subyacente solo cuando maneje situaciones inesperadas y detecte errores.

Digit y los robots con patas que seguirán aún tienen un largo camino por recorrer. Pero sus diseñadores están convencidos de que cambiarán el mundo. Su impacto podría ser tan grande como el automóvil en términos de cambios en los estilos de vida e incluso patrones de tráfico y aspectos de los diseños de la ciudad, donde estos robots prometen transformar la logística y la entrega de paquetes.

En un futuro no muy lejano, a medida que los vehículos ganen autonomía, los fabricantes de automóviles y las compañías de viajes compartidos como Lyft y Uber poseerán grandes flotas de vehículos que transporten personas, con un tráfico máximo durante las horas pico, como hoy. Pero a altas horas de la noche y en medio del día, ¿qué harán estos vehículos automatizados? En lugar de simplemente estar inactivos, podrían transportar paquetes desde los almacenes automáticos a su hogar. Sin embargo, estos vehículos de entrega están limitados en la acera: sin un ser humano, llevar el paquete a la puerta de una casa es un gran desafío. Ahí es donde entran los robots con piernas. Viajando en estos vehículos, cubrirán esos últimos metros. Aunque las ruedas y las alas pueden cumplir algunos de estos roles, en un mundo diseñado para bípedos, ninguna plataforma de movilidad podría ser tan versátil como un robot bípedo.

Fotos: Dan Saelinger. Entrega especial: Digit está aprendiendo a caminar en diferentes tipos de terreno y también a subir escaleras, por lo que algún día puede entregar paquetes directamente a la puerta de su casa.

Los robots de entrega formarán parte de un sistema de logística cada vez más automatizado que va de los fabricantes y los distribuidores directamente a su puerta. Este sistema reducirá los costos de envío hasta que sea significativamente menos costoso recibir los artículos en su hogar que comprarlos en un almacén grande, bien iluminado, con calefacción, y accesible para personas. Se volverán superfluas las grandes tiendas que hoy venden lo que son, en esencia, productos básicos. La gente todavía disfrutará de las compras en la tienda de ciertos productos, por supuesto. Pero para los comestibles de la semana, los robots de entrega le ahorrarán tiempo y dinero.

La locomoción bípeda también ayudará a poner robots en nuestros hogares y negocios. Los robots que pueden moverse por las escaleras y los entornos abarrotados mientras interactúan de manera segura con los humanos a nivel de los ojos y a escala humana, nos permitirán envejecer con gracia en nuestros propios hogares. Ayudarán a llevar las cosas y servirán como dispositivos de telepresencia, permitiendo a los familiares y amigos usar el robot para hablar con las personas de forma remota y hacerles compañía.

Los robots con piernas también irán a donde es peligroso que vayan los humanos. Se lanzarán en paracaídas a los incendios forestales para recopilar datos en tiempo real, se apresurarán a entrar a edificios incendiados para buscar ocupantes, o ingresar a zonas de desastre, como la central nuclear de Fukushima Daiichi, para explorar áreas de difícil acceso. Llevarán a cabo inspecciones periódicas de los espacios internos de las represas hidroeléctricas y explorarán las minas abandonadas, para que no tengamos que hacerlo nosotros.

Se deben resolver muchos desafíos para llevarnos a ese futuro. Pero el autor está convencido de que la comunidad robótica puede hacer que esta tecnología sea práctica. Será un pequeño paso para un robot, un gran salto para la humanidad.

Este artículo es una adaptación al español del que aparece en la edición impresa de IEE Spectrum de marzo de 2019 como «Walk This Way».

Sobre el autor:

Jonathan Hurst es director de tecnología y cofundador de Agility Robotics, así como profesor asociado de robótica y profesor de la Facultad de Ingeniería Dean en Oregon State University. Él tiene un B.S. en ingeniería mecánica y un M.S. y Ph.D. en robótica, todo de la Universidad Carnegie Mellon. Su investigación universitaria se centra en la comprensión de las mejores prácticas de ciencia e ingeniería fundamentales para la locomoción bípeda. Agility Robotics está utilizando esta investigación para desarrollar aplicaciones comerciales para la movilidad con patas robóticas.