Los insectos en general son infaliblemente impresionantes por lo inteligentes y capaces que son, con un mínimo absoluto de detección y poder de cómputo. Cuando las cosas empiezan a ponerse realmente interesantes es cuando los insectos tienen que volverse inteligentes para manejar entornos especialmente difíciles. Las hormigas del desierto son un gran ejemplo de esto: mientras que la mayoría de las hormigas dependen de los senderos de las feromonas para navegar (recorren los senderos de su olor para regresar al nido), el calor del desierto significa que las feromonas no duran mucho. En cambio, las hormigas del desierto se basan en una variedad de técnicas, que incluyen el conteo de pasos, el flujo óptico, los puntos de referencia y, especialmente, la navegación solar.

Parece que estas técnicas podrían ser útiles para los robots pequeños y económicos que exploran el sistema solar, donde el GPS no está disponible y los sensores sofisticados vienen con un presupuesto de masa y energía para igualar. En Science Robotics, los investigadores describen cómo construyeron un robot con herramientas de navegación inspiradas en las hormigas del desierto, y pudieron hacer que deambulara un poco y que encontrara su camino a casa sin GPS, SLAM o algo un poco más complejo.

Lo primero que hay que entender es cómo navegan las hormigas del desierto. En general, el sistema que utilizan se denomina «integración de ruta», que es esencialmente el mismo que llamaríamos «recuento muerto». Al hacer un seguimiento de las distancias y direcciones recorridas en el tiempo, las hormigas pueden calcular la ruta más directa hacia atrás. a donde empezaron

Básicamente, si la hormiga se dirige al norte por un tiempo, y luego al este por el doble de tiempo, sabe que al viajar al sur y al oeste (el doble de largo), terminará bastante cerca de su posición inicial, y una vez que esté cerca, Puede reconocer visualmente puntos de referencia para volver exactamente a su nido.

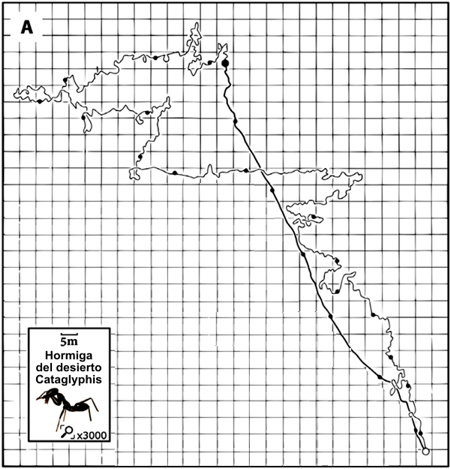

Las hormigas del desierto son notablemente buenas en esto, como lo muestra la siguiente figura. Después de un viaje de ida y vuelta de casi 600 metros a lo largo de unos 20 minutos, la hormiga de un centímetro de longitud puede trazar una línea más o menos exactamente recta directamente a su nido en solo seis minutos.

Imagen: Aix Marseille University / CNRS / ISM Una hormiga del desierto C. fortis usa la «integración del camino» para encontrar su camino de regreso a su nido. La línea delgada muestra la trayectoria de salida (592.1 metros), con pequeños puntos negros que representan marcas de tiempo (cada 60 segundos). La hormiga regresó directamente a su nido (línea gruesa, 140.5 m de largo). El círculo pequeño (abajo a la derecha) marca la entrada del nido, y el negro grande muestra la ubicación de alimentación (centro superior).

Para que la integración del camino funcione, la hormiga debe rastrear dos cosas separadas: la distancia y la dirección. La distancia es la más fácil por mucho, ya que la hormiga puede usar una combinación (muy familiar para los robots) de conteo de zancadas y flujo óptico. La dirección es complicada: es bien sabido que las hormigas y otros insectos pueden usar el Sol para navegar, rastrear su ubicación en el cielo y corregir la rotación de la Tierra y el consiguiente movimiento aparente del Sol a lo largo del tiempo. Esto solo funcionaría cuando está realmente soleado, excepto que los ojos de las hormigas tienen fotorreceptores que son sensibles a la luz polarizada, lo que puede indicar la dirección del Sol, incluso si está nublado. Las hormigas también son sensibles a los rayos UV, lo que les ayuda a ver el Sol a través de la capa de nubes y el follaje.

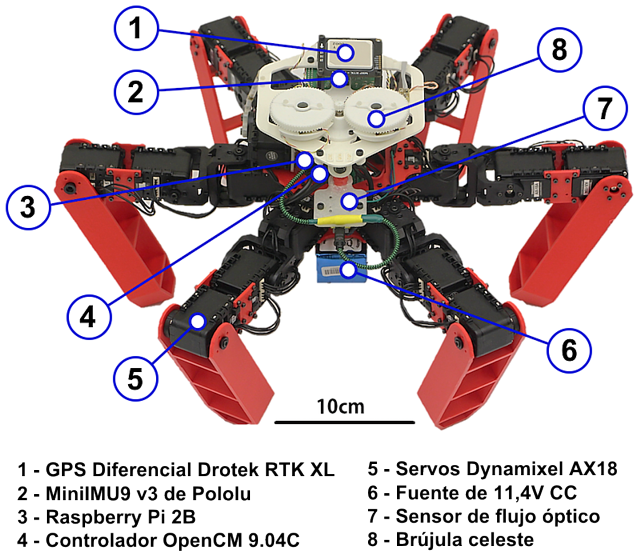

AntBot es un intento de replicar los sistemas de detección de las hormigas del desierto para ver qué tan bien un sistema autónomo podría usarlas para la navegación inspirada en las hormigas. AntBot es un hexápodo de 2,3 kilogramos, cuyas especificaciones físicas específicas no son realmente tan importantes para los fines de esta investigación. Lo que es importante son los sensores de AntBot, que incluyen un sensor óptico de flujo bioinspirado y una «brújula celeste inspirada en insectos» que consiste en un par de sensores de luz UV con polarizadores lineales giratorios. La brújula analiza la relación logarítmica entre los datos de estos dos sensores para determinar el ángulo de polarización de la luz entrante, que utiliza para determinar dónde está el Sol y, por lo tanto, en qué dirección está apuntando. AntBot puede hacerlo con mucha precisión: El error mediano fue de solo 0,02 ° cuando el cielo estaba ligeramente nublado, 0,59 ° bajo un cielo nublado.

Al combinar el seguimiento de la distancia del flujo óptico, el conteo de pasos y la navegación celeste al igual que la hormiga del desierto, probablemente no le sorprenda saber que AntBot pudo deambular repetidamente al azar en una distancia de unos 14 metros y luego regresar con éxito a su punto de partida. Esto es bueno, pero AntBot aún tiene mucho trabajo por hacer para demostrar que es tan talentoso como una hormiga, como señalan los investigadores:

“En su forma actual, AntBot tiene un diámetro de 45 cm y caminó a una velocidad de unos 10 cm/s durante los experimentos, mientras que las hormigas C. fortis desert tienen solo 1 cm de largo. Como se muestra en la Fig. 1A, la trayectoria de la hormiga mide 732,6 m. Por lo tanto, AntBot debería haber cubierto más de 32 km para poder compararlo adecuadamente con el rendimiento de navegación de las hormigas. Aunque AntBot puede caminar a velocidades de hasta 90 cm s, la navegación a gran escala requerirá mejorar los actuadores y la fuente de alimentación del robot hexápodo. Estas mejoras permitirán probar el modo PI-Full en contextos más naturales, como los terrenos escarpados en un entorno saturado (bosques) donde la vista del cielo a menudo está inhibida por la presencia de ramas y hojas en el campo visual de la brújula celeste.”

Es posible que los insectos hayan sido los primeros en descubrir este truco de luz polarizada, pero es posible que los humanos hayan estado usando una técnica similar para ayudarlos a navegar durante siglos. Hay algunas pruebas que sugieren que los vikingos (así como las culturas marineras posteriores que probablemente tuvieron la idea de los vikingos) podrían haber confiado en la luz polarizada para encontrar la ubicación del sol bajo un cielo cubierto usando una piedra solar, una de una pequeña cantidad de minerales que son birrefringentes. Los minerales birrefringentes son polarizadores, y cuando la luz entra en ellos, se divide en dos rayos que toman diferentes caminos a través de la piedra dependiendo de donde la fuente de luz es relativa a la piedra. Al mirar a través de la piedra hacia el cielo, es posible usar la birrefringencia para determinar dónde está el Sol con una precisión de unos pocos grados, incluso si está completamente nublado, o si el Sol está por debajo del horizonte. Todo lo que se necesita es un poco de luz solar, y una piedra solar funcionará.

El mineral birrefringente más común es la calcita, y los vikingos habrían tenido acceso a eso. Algunas leyendas vikingas se refieren directamente a las piedras solares, y las simulaciones han demostrado que el uso de una piedra solar podría haber tenido un gran impacto en la capacidad de los vikingos para realizar viajes prolongados a través del océano abierto. Los barcos vikingos y los sitios de entierro no han producido mucha calcita, pero es más frágil que los minerales y no necesariamente duraría tanto tiempo bajo el agua o en el suelo. Y si no terminaron usando algo como esto para navegar, bueno, realmente deberían haberlo hecho, porque tanto las hormigas como los robots están obteniendo grandes resultados con eso.

“AntBot: A six-legged walking robot able to home like desert ants in outdoor environments”

(«AntBot: un robot andante de seis patas capaz de vivir como hormigas del desierto en ambientes al aire libre»), por J. Dupeyroux; JR Serres; S. Viollet en la Universidad Aix de Marsella en Marsella, Francia, aparece en la edición actual de Science Robotics.