Científicos del Instituto Tecnológico de Massachusetts (MIT) presentaron ayer un estudio en el que demostraban cómo un guante de bajo costo, recubierto con una red de sensores, podría reconocer objetos por medio de la presión, y ser utilizado en prótesis o robots, entre otros.

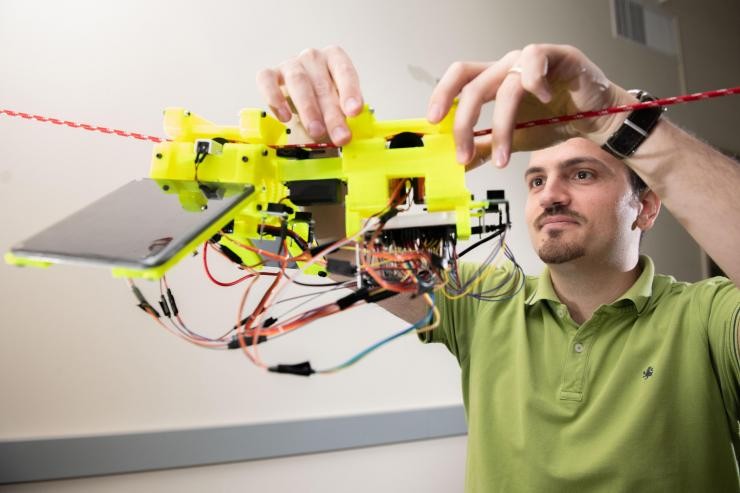

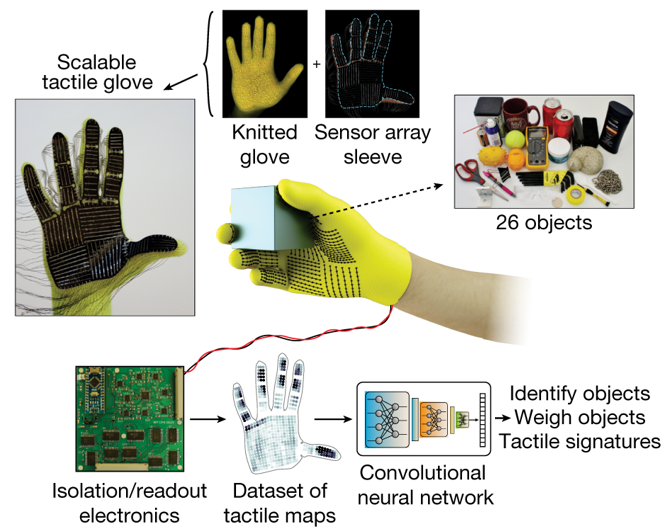

Se trata del proyecto Scalable TActile Glove (STAG), del Laboratorio de Ciencias de la Computación e Inteligencia Artificial, que creó este dispositivo de bajo costo, equipado con unos 550 sensores diminutos en casi toda la mano puede transmitir información en tiempo real.

En detalle, el guante capta cambios de presión por medio de una red de fibras conductoras —conocida técnicamente como una Red Neural Convolucional—, que procesan los datos con un algoritmo de sus sensores y buscan una coincidencia con objetos específicos para identificarlos.

“La información táctil recogida se proyecta sobre la forma de una mano humana, para que podamos entender fácilmente el contexto espacial”, explicó el director de la investigación, Subramanian Sundaraman a los medios. Y añadió: “Se podría considerar que el guante es como una cámara deformable que mide espacialmente las presiones o las fuerzas, lo que no es muy distinto a lo que ocurre en el mundo natural”.

En un artículo publicado en Nature, los investigadores describen un conjunto de datos que compilaron utilizando el STAG con 26 objetos comunes, entre ellos una lata de refresco, tijeras, una pelota de tenis, cuchara, bolígrafo y taza. Usando el conjunto de datos, el sistema predijo las identidades de los objetos con una precisión de hasta el 76 por ciento.

El guante, que sólo cuesta US$10 dólares, también puede predecir los pesos correctos de la mayoría de los objetos dentro de unos 60 gramos.

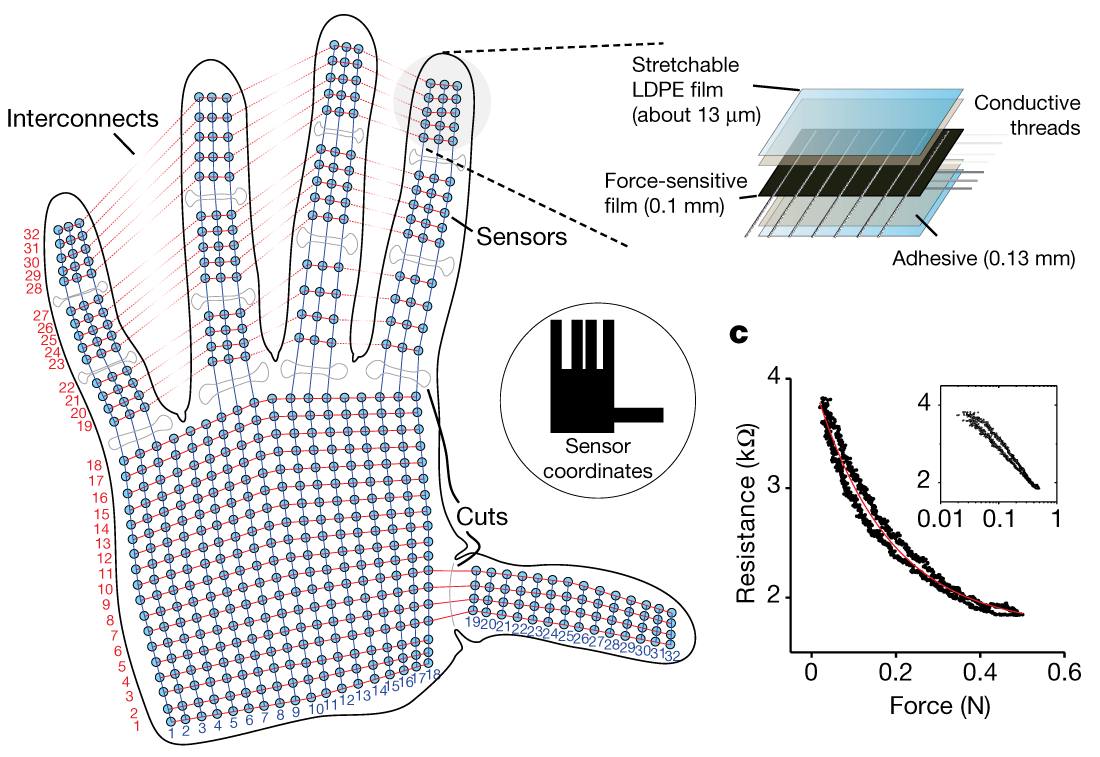

STAG está laminado con un polímero eléctricamente conductor que cambia la resistencia a la presión aplicada. Los investigadores cosieron hilos conductores a través de orificios en la película de polímero conductor, desde la punta de los dedos hasta la base de la palma. Los hilos se superponen de una manera que los convierte en sensores de presión. Cuando alguien que usa el guante siente, levanta, sujeta y suelta un objeto, los sensores registran la presión en cada punto.

Los hilos se conectan desde el guante a un circuito externo que traduce los datos de presión en «mapas táctiles», que son esencialmente videos breves de puntos que crecen y se contraen en un gráfico de una mano. Los puntos representan la ubicación de los puntos de presión, y su tamaño representa la fuerza: cuanto más grande es el punto, mayor es la presión.

A partir de esos mapas, los investigadores compilaron un conjunto de datos de aproximadamente 135.000 cuadros de video de interacciones con 26 objetos. Esos marcos pueden ser utilizados por una red neuronal para predecir la identidad y el peso de los objetos, y proporcionar información sobre la comprensión humana.

Para identificar objetos, los investigadores diseñaron una red neuronal convolucional (CNN), que generalmente se usa para clasificar imágenes, para asociar patrones de presión específicos con objetos específicos. Pero el truco fue elegir marcos de diferentes tipos de agarres para obtener una imagen completa del objeto.

La idea era imitar la forma en que los humanos pueden sostener un objeto de diferentes maneras para reconocerlo, sin usar su vista. De manera similar, la red neuronal convolucional de los investigadores elige hasta ocho cuadros semi-aleatorios del video que representan las capturas más diferentes, por ejemplo, sosteniendo una taza desde la parte inferior, superior y del mango.

El sistema podría mejorar la comprensión del funcionamiento del tacto, y de esta manera cómo se controlan las manos; una información que para algunos investigadores podría utilizarse para incorporar sensores táctiles a miembros artificiales, o partes mecánicas, y así revolucionar el desarrollo de prótesis y manos robóticas.

La red nerviosa de los mamíferos, dicen algunos, es todo un prodigio. En ella miles de millones de sensores distribuidos por la piel envían mensajes a nuestro cerebro, discriminan qué es importante y qué no, siendo clave para nuestras experiencias e incluso para la supervivencia.

Artículos Relacionados:

■ Dando sentido del tacto a los robots

■ Una prótesis que restaura la sensación de dónde está tu mano

■ Ver a través de los ojos de un robot ayuda a personas con grandes deficiencias motoras

■ Crean piel electrónica resistente al agua, sensible y con capacidad de auto-reparación